الذكاء الاصطناعي والتعلم الآلي في النزاعات المسلحة

في وقت يشهد العالم فيه تزايد النزاعات وسرعة التغير التكنولوجي، يتعين على اللجنة الدولية فهم تأثير التكنولوجيات الجديدة على الأشخاص المتضررين من النزاعات المسلحة، وتصميم حلول إنسانية تلبي احتياجات الأشخاص الأكثر عرضة للمخاطر التي تمثلها هذه التكنولوجيات.

وتواجه اللجنة الدولية، على غرار العديد من المنظمات في شتى القطاعات والمناطق، صعوبة بالغة في التعامل مع الآثار الناجمة عن الذكاء الاصطناعي والتعلم الآلي في عملها. ومن الجدير بالذكر أن الذكاء الاصطناعي هو استخدام أنظمة الكمبيوتر لتنفيذ مهام تتطلب إدراكًا أو تخطيطًا أو استدلالًا أو تعلمًا، وهي المهام التي ترتبط في المعتاد بالذكاء البشري. وأنظمة التعلم الآلي هي أنظمة ذكاء اصطناعي يتم "تدريبها" على البيانات و"التعلم" منها، وتحدد هذه البيانات في نهاية الأمر الطريقة التي تعمل بها تلك الأنظمة. ونظرًا لأنها أدوات برمجية أو خوارزميات من الممكن تطبيقها على مهام عديدة مختلفة، فقد يترتب على استخدامها آثار بعيدة الأثر ولا يزال فهمها منقوصًا.

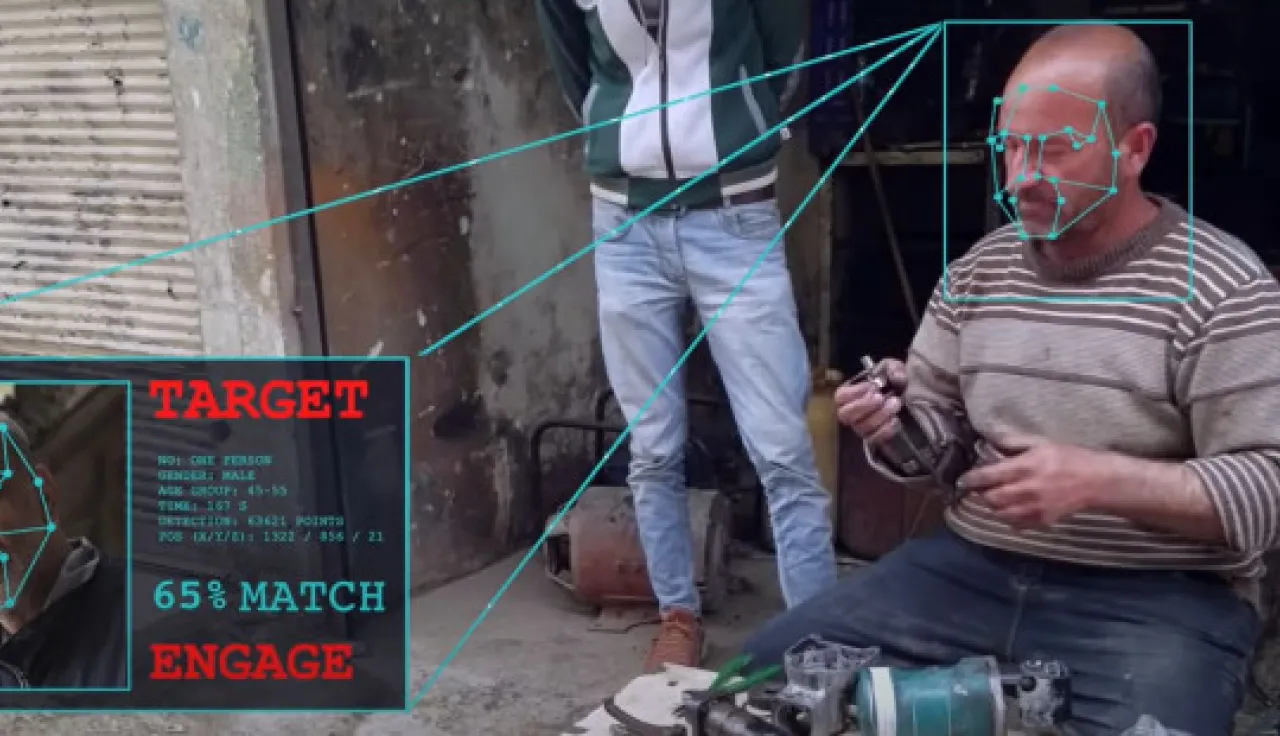

وهناك مجالان واسعان - ومتمايزان - لتطبيق الذكاء الاصطناعي والتعلم الآلي توليهما اللجنة الدولية اهتمامًا خاصًا: أولًا، استخدامهما في شن الحروب أو أعمال العنف الأخرى؛ وثانيًا، استخدامهما في العمل الإنساني لتقديم المساعدة وتوفير الحماية لضحايا النزاعات المسلحة.