Armes autonomes - Q & R

Vers la fin du contrôle humain sur l’usage de la force ? - Les avancées technologiques dans le domaine de l’armement supposent que les décisions relatives à l’usage de la force sur le champ de bataille pourraient être prises toujours plus souvent par des machines, indépendamment de toute intervention humaine. Nous examinerons ci-après les possibles implications qu’un changement si radical pourrait avoir sur la façon de faire la guerre, tout en émettant des mises en garde quant à l’emploi de ces armes lorsque le respect du droit international humanitaire ne peut être garanti.

Comment des armes qui fonctionnent sans intervention d’un opérateur extérieur pourraient-elles faire une distinction entre un combattant et un civil ? Comment seraient-elles capables d’annuler une attaque qui risquerait d’avoir des effets disproportionnés sur les civils ? Et comment pourraient-elles être tenues responsables de violations du droit international humanitaire et avoir à en rendre compte ?

Autant d’interrogations qui subsistent, et face auxquelles le CICR appelle les États à réfléchir au coût humain et aux incidences sur le droit international humanitaire que l’utilisation de ces nouvelles technologies de guerre pourrait avoir. C’est pour examiner toutes ces questions encore sans réponse qu’il a convoqué, en mars 2014, une réunion internationale d’experts.

Qu’entend-on par armes autonomes ?

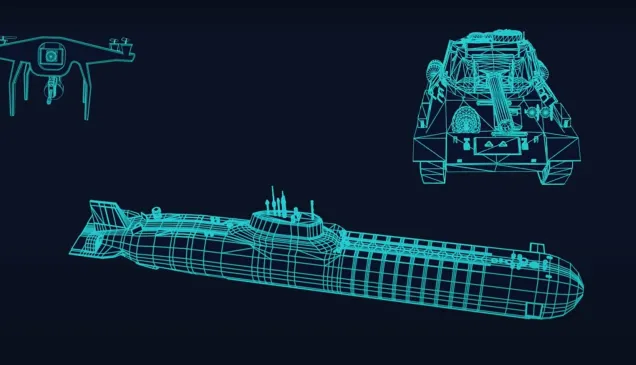

Les systèmes d’armes autonomes (connus également sous le nom d’armes létales autonomes ou de « robots tueurs ») sont capables de repérer, d’identifier et d’attaquer des cibles sans intervention d’un opérateur humain. Certaines armes dotées de ces « fonctions essentielles » sont déjà en usage aujourd’hui. C’est par exemple le cas de certains systèmes d’armement défensifs capables d’intercepter de façon autonome des missiles, des roquettes et des obus d’artillerie de courte portée – ou encore des avions de chasse. Actuellement, les systèmes de ce genre sont généralement fixes et ne fonctionnent de façon autonome que sur de courtes périodes, dans des situations très précises (par ex. dans des endroits à faible concentration de personnes ou de biens civils), et contre des types de cibles restreints (principalement des munitions et des véhicules). Les systèmes d’armes autonomes du futur pourraient eux bientôt être opérationnels ; ils ne seraient pas soumis à des limites spatio-temporelles aussi strictes et seraient capables de s’adapter à toute une série de situations en constante évolution et, vraisemblablement, de frapper directement des cibles humaines.

Les drones entrent-ils dans la catégorie des armes autonomes ?

Les armes autonomes fonctionnent indépendamment de toute intervention humaine, ce qui n’est pas le cas des aéronefs sans pilote (aussi appelés drones ou aéronefs pilotés à distance) actuellement en usage. Si les drones peuvent être dotés d’un certain degré d’autonomie (certains disposent de systèmes de pilotage et de navigation automatiques), ils ont besoin d’opérateurs humains pour sélectionner leurs cibles et pour activer, diriger et mettre à feu les munitions qu’ils transportent.

Des appels ont été lancés en faveur d’un moratoire ou d’une interdiction de la mise au point, de la production et de l’utilisation des armes autonomes. Le CICR soutient-il ces appels ?

Pour l’heure, le CICR ne s’associe pas à ces appels. Toutefois, l’institution demande instamment aux États d’examiner les questions fondamentales sur les plans juridique, éthique et sociétal, que soulève l’emploi d’armes autonomes, avant qu’elles ne soient mises au point ou déployées dans les conflits armés, ainsi que le prescrit le droit international humanitaire. Le CICR est préoccupé par le coût potentiel en vies humaines des armes létales autonomes et s’interroge sur la mesure dans laquelle leur utilisation peut être conforme aux dispositions du droit international humanitaire

Quelle est la position du droit international humanitaire sur les armes autonomes ?

Il n'existe aucune règle spécifique concernant les armes autonomes. Cependant, le droit dispose que dans la mise au point ou l’acquisition d'une nouvelle arme, de nouveaux moyens ou d’une nouvelle méthodes de guerre, les États ont l’obligation de déterminer si l'emploi en serait interdit, dans certains circonstances ou en toutes circonstances, par le droit international, et notamment le Protocole additionnel I aux Conventions de Genève.

En d'autres termes, les règles du droit international humanitaire qui régissent de longue date la conduite des hostilités, en particulier les principes de distinction, de proportionnalité et de précaution dans l'attaque, s'appliquent à toutes les nouvelles armes et à toutes les nouvelles technologies de guerre, aux armes autonomes y compris. Aussi est-il absolument essentiel, face à l’évolution rapide des nouvelles technologies d’armement, d’en examiner régulièrement la licéité.

Le défi majeur pour tout État qui met au point ou acquiert des systèmes d’armes autonomes est de s'assurer que ceux-ci peuvent être utilisés en conformité avec toutes ces règles. Il est par exemple difficile de savoir comment ces armes pourraient opérer une distinction non seulement entre les civils et les combattants, ainsi que l’exige le principe de distinction, mais aussi entre les combattants actifs et les personnes qui sont hors de combat ou qui expriment leur intention de se rendre, ou encore entre les civils prenant directement part aux hostilités et les civils armés, comme les membres des forces de l’ordre ou les chasseurs, qui sont eux aussi protégés contre les attaques directes.

L’usage d’armes autonomes doit également être subordonné au principe de proportionnalité, selon lequel les pertes en vies humaines dans la population civile causées incidemment par une attaque contre un objectif militaire ne doivent pas être excessives par rapport à l’avantage militaire concret et direct attendu. Leur emploi, enfin, doit être soumis à l’obligation de prendre des précautions dans l’attaque, afin de réduire au minimum le nombre de victimes civiles.

L’analyse des capacités technologiques actuelles et des progrès prévisibles dans ce domaine fait ressortir qu’il est peu probable que des machines puissent un jour être programmées pour prendre les décisions qui s’imposent. D’où les sérieux doutes qui existent aujourd’hui quant à la perspective que ces systèmes d’armement soient utilisés dans le respect du droit international humanitaire, sauf dans des cas de figure exceptionnels et dans des situations absolument sans équivoque.

Quelles pourraient être les conséquences de l’emploi de systèmes d’armes autonomes dans les conflits armés ?

Certains partisans de ce type d’armements soutiennent que les armes autonomes pourraient être programmées pour fonctionner avec davantage de « précaution » et de précision que celles qui sont actionnées par des opérateurs humains, et qu’elles pourraient par conséquent servir à limiter les pertes civiles involontaires. Leurs adversaires rétorquent de leur côté que ces systèmes d’armement seront toujours dépourvus du discernement humain nécessaire pour garantir un recours à la force qui soit légitime, et que leur usage risque d’avoir un coût humain plus lourd.

Ces systèmes d’armement posent en outre des questions éthiques de premier ordre, et leur utilisation à large échelle représenterait un changement radical dans la conduite des hostilités. La question fondamentale que tout le monde se pose est de savoir s’il est acceptable, au nom des principes de l’humanité et des exigences de la conscience publique, de laisser des machines prendre des décisions de vie ou de mort de manière indépendante.

Qui serait responsable en cas de violation du droit international humanitaire résultant de l’emploi de systèmes d’armes autonomes ?

En tant que machine, une arme autonome ne saurait être tenue responsable d'une violation du droit international humanitaire. Cela soulève la question, au-delà de la responsabilité évidente des personnes ou des entités qui ont recours à des systèmes comme ceux-ci, de savoir qui serait juridiquement responsable dans le cas où l’emploi d’armes autonomes entraînerait un crime de guerre : l’ingénieur, le programmateur, le fabricant ou le chef militaire qui décide d’activer de tels systèmes ? Si la responsabilité ne saurait être établie comme le prescrit le droit international humanitaire, est-il légal ou éthique d’utiliser des systèmes comme ceux-ci ?

Quels sont les points sur lesquels les États devraient centrer leurs débats ?

L’autonomie accrue de certains systèmes d’armement risque de remplacer les décisions humaines en les déléguant à des machines, ce qui compromettrait toujours plus le contrôle humain sur l’usage de la force. Alors que chacun s’accorde à dire que le contrôle ultime revient à l’homme, il s’agit de réfléchir plus en profondeur à ce qu’on entend par contrôle adéquat, efficace et approprié sur l’usage de la force.

Le CICR invite les États à examiner la question de l’autonomie dans les « fonctions essentielles » des systèmes d’armes existants ou en cours de développement, et à échanger les informations recueillies pour être à même de mieux appréhender le sujet. Il faudra à terme pouvoir répondre à la question essentielle de savoir à partir de quel moment et dans quelles circonstances le contrôle avisé et le jugement éclairé d’un être humain sur le recours à la force risque de disparaître.

Face à toutes ces questions qui n’ont encore pas trouvé de réponse, le CICR appelle les États à veiller à ce qu’il ne soit pas fait recours aux systèmes d’armes autonomes si le respect du droit international humanitaire ne peut être garanti.