El avance de la inteligencia artificial exige que se adopte un enfoque centrado en las personas en las zonas de conflicto

La inteligencia artificial (IA) ha recibido mucha atención en los últimos meses a partir del incremento de robots de chat como ChatGPT, pero no ha ocurrido lo mismo con los posibles usos de la IA en los conflictos armados y su impacto en la población civil. En su visita a Londres a principios de este mes, conversamos con el director general del CICR, Robert Mardini, sobre la IA en el ámbito militar y en el sector humanitario.

¿Cuál es su mensaje para los Estados y otros actores interesados en utilizar la IA y las nuevas tecnologías con fines militares?

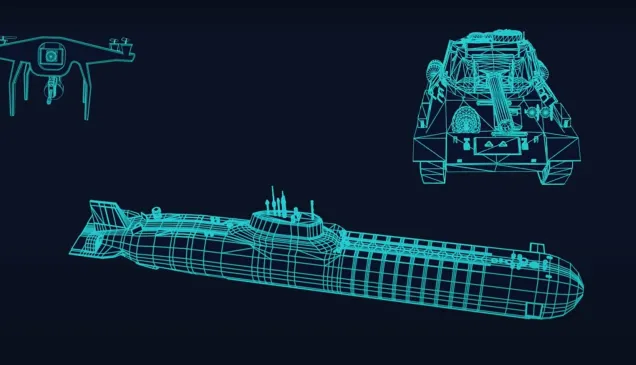

La tecnología militar y la IA se están desarrollando a una velocidad asombrosa, y es preocupante ver que en algunos casos supera la capacidad de la comunidad internacional de acordar marcos rectores eficaces. Siempre se intenta que los avances tecnológicos respalden a la acción humanitaria y beneficien a las personas civiles y a otras personas protegidas en las zonas de conflicto armado, en lugar de aumentar los riesgos a los que se enfrentan.

Desde nuestra perspectiva, las conversaciones en torno a los usos militares de la IA deben incorporar los principios del derecho internacional humanitario tal y como se establecen en los Convenios de Ginebra y sus Protocolos Adicionales. La comunidad internacional debe adoptar un enfoque centrado en las personas respecto del uso de la IA en lugares afectados por conflictos armados. Se necesitan medidas que ayuden a reforzar las protecciones existentes y a mitigar los riesgos remanentes.

¿Cuáles son los riesgos que preocupan al CICR respecto de la IA?

No dudo de que la IA puede ser una herramienta positiva para la acción humanitaria y para las personas a las que queremos ayudar. A la vez, hay muchos riesgos que debemos tener en cuenta.

Por ejemplo, desde nuestra perspectiva de trabajo en zonas de conflicto armado, el empleo de la IA en la toma de decisiones militares, o en armas autónomas, podría plantear riesgos considerables tanto para las personas civiles como para los combatientes.

No podemos aceptar que las decisiones de vida o muerte se deleguen en máquinas o algoritmos. El control y el criterio humanos deben ser una parte fundamental en cualquier decisión que afecte la vida o la dignidad de las personas.

Si analizamos las nuevas tecnologías en sentido más amplio, podemos afirmar que los conflictos armados actuales ya no se limitan a tierra, mar y aire, sino que se libran en el ciberespacio. Los ciberataques pueden tener repercusiones significativas en la población civil, ya que los sistemas y herramientas digitales de los que dependen se degradan, destruyen o interrumpen como parte de una acción militar.

Por ejemplo, cuando un hospital se convierte en blanco de un ciberataque, la prestación de asistencia médica a la población civil se ve obstaculizada. Cuando las infraestructuras de suministro de agua o de energía son atacadas en la esfera cibernética, los servicios esenciales se ven interrumpidos, y son las personas civiles las que pagan el precio. Los ciberataques que interrumpen las redes de comunicaciones impiden el acceso a información precisa y actualizada por parte de las personas civiles, y pueden hacer que pierdan el contacto con sus seres queridos en momentos críticos.

Llevamos años enunciando con toda claridad que las normas de la guerra, los Convenios de Ginebra, son aplicables en el ciberespacio. También hemos investigado la idea de un emblema digital de la cruz roja y de la media luna roja, que facilitaría, para quienes llevan a cabo operaciones cibernéticas durante un conflicto armado, la identificación y el resguardo de las instalaciones protegidas.

¿Qué prioridad se le dio al tema de la IA en sus reuniones?

Ocupó un lugar muy destacado para todos los presentes. Sin duda, es una prioridad importante para el Reino Unido, como puso de relieve la Cumbre mundial sobre seguridad de la IA, que se celebrará en este país a fin de año.

Tenemos la suerte de mantener un diálogo sólido y constructivo con el Reino Unido que nos permite plantear nuestras preocupaciones humanitarias en torno a cuestiones relacionadas con la IA y las nuevas tecnologías en zonas de conflicto armado.

Nuestra postura ante todos los Estados cuando se habla de IA en escenarios militares es que deben adoptar un enfoque centrado en las personas y que cualquier uso de IA en sistemas de armas debe abordarse con extremo cuidado.

El Reino Unido se prepara para celebrar la conferencia sobre IA a fin de este año, y esperamos contribuir a estos debates tan importantes para que el DIH se incluya en la conversación.

Pleased to be in London today to meet with Minister @AndrewmitchMP and the @FCDOGovUK team.

— Robert Mardini (@RMardiniICRC) July 4, 2023

The @ICRC is grateful for our partnership and values the UK’s role in helping to ensure IHL remains a priority in a changing world. https://t.co/hMmvESp40w

¿Hasta qué punto es preocupante la creciente participación de personas civiles en el campo de batalla digital?

Plantea varias preocupaciones. En virtud del DIH, las partes en un conflicto armado deben hacer la distinción entre personas civiles y combatientes, así como entre bienes de carácter civil y objetivos militares. Estas distinciones suelen ser evidentes en los conflictos armados físicos, pero la guerra digital puede disminuir la nitidez de esta línea.

Dada la digitalización de la sociedad y del campo de batalla, nunca ha sido tan fácil que las personas civiles participen en actividades militares cibernéticas y digitales. De hecho, hay una tendencia a que las personas civiles participen cada vez más en los conflictos, en algunos casos con contribuciones directas a las operaciones militares a través de medios digitales.

Las normas de la guerra son muy claras: las personas civiles están protegidas contra los ataques a menos que participen directamente en las hostilidades. A nivel jurídico, es complejo determinar si su participación en la guerra digital se considera participación directa en las hostilidades. Pero, si los Estados las alientan participar en tales actividades, las exponen al riesgo potencial de sufrir daños graves.

Por lo tanto, debemos respetar la clara línea que separa a civiles de militares. Los Estados deben abstenerse de alentar a las personas civiles a participar directamente en las hostilidades o, al menos, tomar las medidas necesarias para que tengan plena conciencia de los riesgos a los que pueden exponerse y de cómo pueden protegerse.